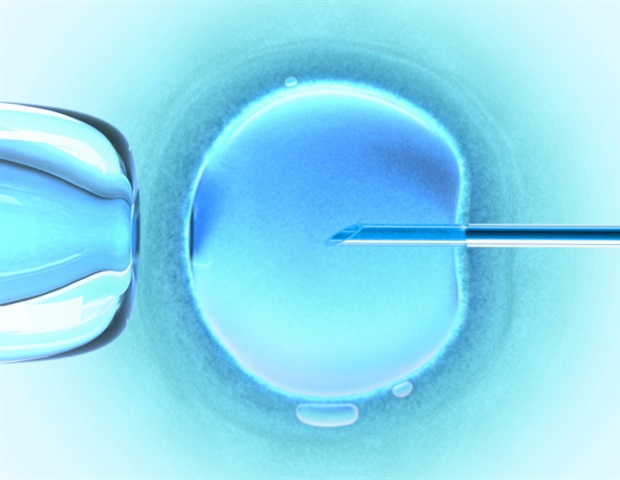

ChatGPT de OpenAI promete como asesor de fertilidad, a pesar de sus limitaciones

Por el Dr. Priyom Bose, Ph.D. 25 de mayo de 2023 Revisado por Benedette Cuffari, M.Sc.

Por el Dr. Priyom Bose, Ph.D. 25 de mayo de 2023 Revisado por Benedette Cuffari, M.Sc.

Tanto los profesionales sanitarios como los pacientes utilizan Internet para obtener información sanitaria rápida. Por lo tanto, no es de extrañar que los contenidos orientados a la fertilidad se hayan explorado ampliamente a lo largo de los años. Por desgracia, aunque en una sola búsqueda en Google de la palabra "infertilidad" aparecen millones de resultados, la exactitud médica de estos contenidos no está verificada.

Los avances en el Procesamiento del Lenguaje Natural (PLN), una rama de la Inteligencia Artificial (IA), han permitido a los ordenadores aprender y utilizar el lenguaje humano para comunicarse. Recientemente, OpenAI ha desarrollado un chatbot de IA llamado ChatGPT, que permite a los usuarios humanos mantener conversaciones con una interfaz informática.

Cómo su período afecta a sus posibilidades de quedar embarazada

La deficiencia de vitamina D persiste a pesar de la facilidad de acceso; un estudio sugiere la necesidad de suplementos a medida

Estudio: La promesa y el peligro de utilizar un gran modelo lingüístico para obtener información clínica: ChatGPT tiene un gran rendimiento como herramienta de asesoramiento sobre fertilidad con limitaciones

Estudio: La promesa y el peligro de utilizar un gran modelo lingüístico para obtener información clínica: ChatGPT tiene un gran rendimiento como herramienta de asesoramiento sobre fertilidad con limitaciones

Un estudio reciente de Fertility and Sterility utilizó la fertilidad como dominio para probar el rendimiento de ChatGPT y evaluar su uso como herramienta clínica.

La evolución reciente de Chat

GPTLa singularidad de ChatGPT puede atribuirse a su capacidad para realizar tareas lingüísticas, como escribir artículos, responder preguntas o incluso contar chistes. Estas características se desarrollaron a raíz de los recientes avances en nuevos algoritmos de aprendizaje profundo (deep learning, DL).

Por ejemplo, Generative Pretrained Transformer 3 (GPT-3) es un algoritmo de DL que destaca por su gran cantidad de datos de entrenamiento: 57.000 millones de palabras y 175.000 millones de parámetros procedentes de diversas fuentes.

En noviembre de 2022, ChatGPT se lanzó inicialmente como una versión actualizada del modelo GPT-3.5. A partir de entonces, se convirtió en la aplicación de mayor crecimiento de todos los tiempos, con más de 100 millones de usuarios en los dos meses siguientes a su lanzamiento.

Aunque existe la posibilidad de utilizar ChatGPT como herramienta clínica para que los pacientes accedan a información médica, hay algunas limitaciones en el uso de este modelo para la información clínica.

Historias relacionadas

- Un estudio revela que un mayor IMC y el tabaquismo aumentan el tiempo hasta la concepción

- ¿Existe una relación entre el hecho de que las mujeres vistan de rojo, la fertilidad y el objetivo de aumentar el atractivo?

- Una investigación evalúa los efectos de los agentes físicos en la fertilidad masculina

A partir de febrero de 2023, ChatGPT fue entrenado con datos hasta 2021; por lo tanto, no está equipado con los datos más recientes. Además, una de las preocupaciones críticas en relación con su uso es la producción de información plagiada e inexacta.

Debido a la facilidad de uso y al lenguaje similar al humano, los pacientes se sienten atraídos a utilizar esta aplicación para hacer preguntas sobre su salud y recibir respuestas. Por lo tanto, es imperativo caracterizar el rendimiento de este modelo como herramienta clínica y dilucidar si proporciona respuestas engañosas.

Acerca del estudio

El presente estudio probó la versión "Feb 13" de ChatGPT para evaluar su consistencia a la hora de responder a preguntas clínicas relacionadas con la fertilidad que un paciente podría plantear al chatbot. El rendimiento de ChatGPT se evaluó en función de tres dominios.

El primer dominio se asoció a preguntas frecuentes sobre infertilidad en el sitio web de los Centros para el Control y la Prevención de Enfermedades (CDC) de Estados Unidos. Se tuvieron en cuenta un total de 17 preguntas frecuentes, como "¿qué es la infertilidad?" o "¿cómo tratan los médicos la infertilidad?".

Estas preguntas se introdujeron en ChatGPT durante una única sesión. Las respuestas producidas por ChatGPT se compararon con las respuestas proporcionadas por CDC.

En el segundo ámbito se utilizaron encuestas importantes relacionadas con la fertilidad. Para ello se utilizó el cuestionario Cardiff Fertility Knowledge Scale (CFKS), que incluye preguntas sobre fertilidad, conceptos erróneos y factores de riesgo para el deterioro de la fertilidad. Además, también se utilizó el cuestionario de la encuesta Fertility and Infertility Treatment Knowledge Score (FIT-KS) para evaluar el rendimiento de ChatGPT.

El tercer dominio se centró en evaluar la capacidad del chatbot para reproducir el estándar clínico a la hora de proporcionar asesoramiento médico. Este dominio se estructuró basándose en la Opinión del Comité de la Sociedad Americana de Medicina Reproductiva (ASRM) "Optimización de la Fertilidad Natural".

Conclusiones del estudio

ChatGPT proporcionó respuestas a las preguntas del primer dominio que se parecían a las respuestas proporcionadas por los CDC sobre infertilidad. La longitud media de las respuestas proporcionadas por los CDC y ChatGPT fue la misma.

Al analizar la fiabilidad del contenido proporcionado por ChatGPT, no se encontraron hechos significativamente diferentes entre los datos de CDC y las respuestas producidas por ChatGPT. Tampoco se observaron diferencias en la polaridad de los sentimientos ni en la subjetividad. En particular, sólo el 6,12% de las afirmaciones fácticas de ChatGPT se identificaron como incorrectas, mientras que una afirmación se citó como referencia.

En el segundo dominio, ChatGPT obtuvo puntuaciones altas correspondientes al percentil 87 de la cohorte internacional de Bunting de 2013 para el CFKS y al percentil 95 basado en la cohorte de Kudesia de 2017 para el FIT-KS. Para todas las preguntas, ChatGPT proporcionó un contexto y una justificación de sus opciones de respuesta. Además, ChatGPT produjo una respuesta no concluyente solo una vez, y la respuesta se consideró ni correcta ni incorrecta.

En el tercer ámbito, ChatGPT reprodujo los hechos que faltaban en los siete enunciados resumidos de "Optimización de la fertilidad natural"; para cada respuesta, ChatGPT subrayó el hecho eliminado del enunciado y no proporcionó hechos en desacuerdo. En este ámbito, se obtuvieron resultados coherentes en todas las administraciones repetidas.

Limitaciones

El presente estudio tiene varias limitaciones, incluida la evaluación de una sola versión de ChatGPT. Recientemente, el lanzamiento de modelos similares, como Microsoft Bing y Google Bard potenciados por IA, permitirá a los pacientes acceder a chatbots alternativos. Por lo tanto, la naturaleza y disponibilidad de estas modalidades están sujetas a rápidos cambios.

Al proporcionar respuestas rápidas, existe la posibilidad de que ChatGPT utilice datos de referencias poco fiables. Además, la coherencia del modelo puede verse afectada durante la siguiente iteración. Por lo tanto, también es importante caracterizar la volatilidad en la respuesta del modelo con diversos datos actualizados.